주제: 타이타닉 생존자 예측하기

작성: 2023-02-05

활용데이터: https://www.kaggle.com/competitions/titanic/data

안녕하세요, WSCODE 루카스입니다.

사이킷런으로 수행하는 타이타닉 생존자 예측해보도록 하겠습니다.

1. 데이터 다운로드

우선, 데이터확보가 필요합니다. 데이터는 kaggle 제공하는 타이타닉 생존자 데이터를 활용하도록 하겠습니다.

하단의 링크를 클릭하시면, 데이터의 간략한 설명 및 각 레이블이 의미하는 값이 무엇인지 설명되어 있습니다.

혹시라도 귀찮으신분들은 데이터파일 참보하였으니 다운로드하셔서 진행하시면 됩니다.

1. 전체 소스코드

우선 전체 소스코드입니다.

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

%matplotlib inline

## 데이터 불러오기

titanic_df = pd.read_csv('./train.csv')

titanic_df.info()

## 데이터 확인 및 EDA

titanic_df['Age'].fillna(titanic_df['Age'].mean(),inplace=True)

titanic_df['Cabin'].fillna('N',inplace=True)

titanic_df['Embarked'].fillna('N',inplace=True)

print('데이터 세트 Null 값 갯수 ',titanic_df.isnull().sum().sum())

print(' Sex 값 분포 :\n',titanic_df['Sex'].value_counts())

print('\n Cabin 값 분포 :\n',titanic_df['Cabin'].value_counts())

print('\n Embarked 값 분포 :\n',titanic_df['Embarked'].value_counts())

titanic_df['Cabin'] = titanic_df['Cabin'].str[:1]

print(titanic_df['Cabin'].head(3))

titanic_df.groupby(['Sex','Survived'])['Survived'].count()

sns.barplot(x='Sex', y = 'Survived', data=titanic_df)

sns.barplot(x='Pclass', y='Survived', hue='Sex', data=titanic_df)

## 입력 age에 따라 구분값을 반환하는 함수 설정. DataFrame의 apply lambda식에 사용.

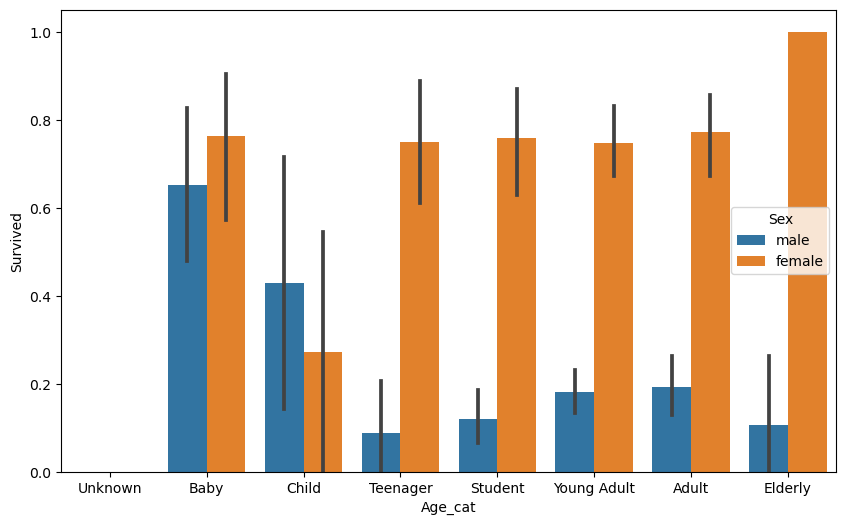

def get_category(age):

cat = ''

if age <= -1: cat = 'Unknown'

elif age <= 5: cat = 'Baby'

elif age <= 12: cat = 'Child'

elif age <= 18: cat = 'Teenager'

elif age <= 25: cat = 'Student'

elif age <= 35: cat = 'Young Adult'

elif age <= 60: cat = 'Adult'

else : cat = 'Elderly'

return cat

# 막대그래프의 크기 figure를 더 크게 설정

plt.figure(figsize=(10,6))

#X축의 값을 순차적으로 표시하기 위한 설정

group_names = ['Unknown', 'Baby', 'Child', 'Teenager', 'Student', 'Young Adult', 'Adult', 'Elderly']

# lambda 식에 위에서 생성한 get_category( ) 함수를 반환값으로 지정.

# get_category(X)는 입력값으로 'Age' 컬럼값을 받아서 해당하는 cat 반환

titanic_df['Age_cat'] = titanic_df['Age'].apply(lambda x : get_category(x))

sns.barplot(x='Age_cat', y = 'Survived', hue='Sex', data=titanic_df, order=group_names)

titanic_df.drop('Age_cat', axis=1, inplace=True)

from sklearn.preprocessing import LabelEncoder

# Null 처리 함수

def fillna(df):

df['Age'].fillna(df['Age'].mean(),inplace=True)

df['Cabin'].fillna('N',inplace=True)

df['Embarked'].fillna('N',inplace=True)

df['Fare'].fillna(0,inplace=True)

return df

# 머신러닝 알고리즘에 불필요한 속성 제거

def drop_features(df):

df.drop(['PassengerId','Name','Ticket'],axis=1,inplace=True)

return df

# 레이블 인코딩 수행.

def format_features(df):

df['Cabin'] = df['Cabin'].str[:1]

features = ['Cabin','Sex','Embarked']

for feature in features:

le = LabelEncoder()

le = le.fit(df[feature])

df[feature] = le.transform(df[feature])

return df

# 앞에서 설정한 Data Preprocessing 함수 호출

def transform_features(df):

df = fillna(df)

df = drop_features(df)

df = format_features(df)

return df

# 원본 데이터를 재로딩 하고, feature데이터 셋과 Label 데이터 셋 추출.

titanic_df = pd.read_csv('./titanic_train.csv')

y_titanic_df = titanic_df['Survived']

X_titanic_df= titanic_df.drop('Survived',axis=1)

X_titanic_df = transform_features(X_titanic_df)

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test=train_test_split(X_titanic_df, y_titanic_df, \

test_size=0.2, random_state=11)

from sklearn.tree import DecisionTreeClassifier

from sklearn.ensemble import RandomForestClassifier

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

# 결정트리, Random Forest, 로지스틱 회귀를 위한 사이킷런 Classifier 클래스 생성

dt_clf = DecisionTreeClassifier(random_state=11)

rf_clf = RandomForestClassifier(random_state=11)

lr_clf = LogisticRegression()

# DecisionTreeClassifier 학습/예측/평가

dt_clf.fit(X_train , y_train)

dt_pred = dt_clf.predict(X_test)

print('DecisionTreeClassifier 정확도: {0:.4f}'.format(accuracy_score(y_test, dt_pred)))

# RandomForestClassifier 학습/예측/평가

rf_clf.fit(X_train , y_train)

rf_pred = rf_clf.predict(X_test)

print('RandomForestClassifier 정확도:{0:.4f}'.format(accuracy_score(y_test, rf_pred)))

# LogisticRegression 학습/예측/평가

lr_clf.fit(X_train , y_train)

lr_pred = lr_clf.predict(X_test)

print('LogisticRegression 정확도: {0:.4f}'.format(accuracy_score(y_test, lr_pr

from sklearn.model_selection import KFold

def exec_kfold(clf, folds=5):

# 폴드 세트를 5개인 KFold객체를 생성, 폴드 수만큼 예측결과 저장을 위한 리스트 객체 생성.

kfold = KFold(n_splits=folds)

scores = []

# KFold 교차 검증 수행.

for iter_count , (train_index, test_index) in enumerate(kfold.split(X_titanic_df)):

# X_titanic_df 데이터에서 교차 검증별로 학습과 검증 데이터를 가리키는 index 생성

X_train, X_test = X_titanic_df.values[train_index], X_titanic_df.values[test_index]

y_train, y_test = y_titanic_df.values[train_index], y_titanic_df.values[test_index]

# Classifier 학습, 예측, 정확도 계산

clf.fit(X_train, y_train)

predictions = clf.predict(X_test)

accuracy = accuracy_score(y_test, predictions)

scores.append(accuracy)

print("교차 검증 {0} 정확도: {1:.4f}".format(iter_count, accuracy))

# 5개 fold에서의 평균 정확도 계산.

mean_score = np.mean(scores)

print("평균 정확도: {0:.4f}".format(mean_score))

# exec_kfold 호출

exec_kfold(dt_clf , folds=5)

from sklearn.model_selection import cross_val_score

scores = cross_val_score(dt_clf, X_titanic_df , y_titanic_df , cv=5)

for iter_count,accuracy in enumerate(scores):

print("교차 검증 {0} 정확도: {1:.4f}".format(iter_count, accuracy))

print("평균 정확도: {0:.4f}".format(np.mean(scores)))

from sklearn.model_selection import GridSearchCV

parameters = {'max_depth':[2,3,5,10],

'min_samples_split':[2,3,5], 'min_samples_leaf':[1,5,8]}

grid_dclf = GridSearchCV(dt_clf , param_grid=parameters , scoring='accuracy' , cv=5)

grid_dclf.fit(X_train , y_train)

print('GridSearchCV 최적 하이퍼 파라미터 :',grid_dclf.best_params_)

print('GridSearchCV 최고 정확도: {0:.4f}'.format(grid_dclf.best_score_))

best_dclf = grid_dclf.best_estimator_

# GridSearchCV의 최적 하이퍼 파라미터로 학습된 Estimator로 예측 및 평가 수행.

dpredictions = best_dclf.predict(X_test)

accuracy = accuracy_score(y_test , dpredictions)

print('테스트 세트에서의 DecisionTreeClassifier 정확도 : {0:.4f}'.format(accuracy))

2. 코드 이해하기

2.1. 탐색적 데이터 분석(EDA, Exploratory Data Analysis)

우선은 데이터가 어떠한 특성을 가지고 있는지를 사전에 탐색하는 작업이 바로 EDA 입니다.

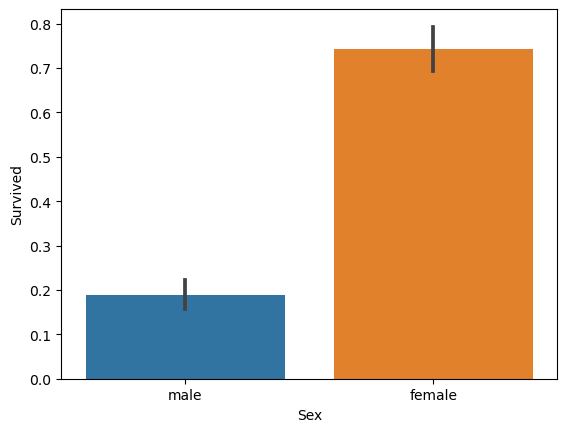

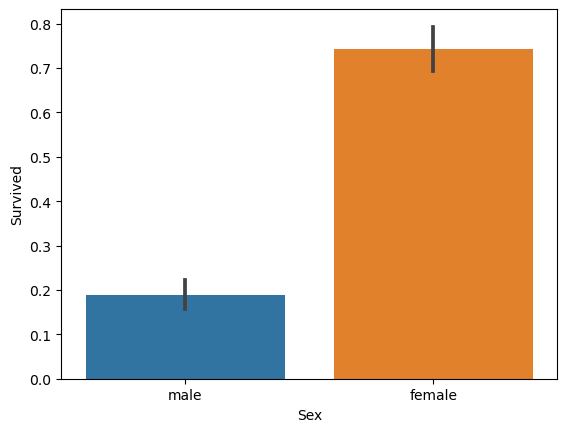

그럼 우선 생존자의 남여 성비구성은 어떤지 확인해보도록 하겠습니다.

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

%matplotlib inline

## 데이터 불러오기

titanic_df = pd.read_csv('./train.csv')

titanic_df.info()

## 데이터 전처리

titanic_df['Age'].fillna(titanic_df['Age'].mean(),inplace=True)

titanic_df['Cabin'].fillna('N',inplace=True)

titanic_df['Embarked'].fillna('N',inplace=True)

print('데이터 세트 Null 값 갯수 ',titanic_df.isnull().sum().sum())

## 데이터 확인

titanic_df.groupby(['Sex','Survived'])['Survived'].count()

sns.barplot(x='Sex', y = 'Survived', data=titanic_df)

sns.barplot(x='Pclass', y='Survived', hue='Sex', data=titanic_df)

해당 데이터만으로 같은 조건에서는 남성보다 여성이 더 생존능력이 뛰어나다 라고 분석을 하는건 너무 성급한 일반화의 오류일 듯합니다.

그럼 과연 왜 여성 생존률이 남성보다 높게 나왔을까요?

아마 필자는 그 이유가 선박 안전 프로토콜 때문이 아닐까싶습니다. 대부분 안전프로토콜의 경우, 어린이 및 노약자, 여성, 남성순으로 대피를 진행합니다. 아마 초반에 구명보트에 이 순서대로 대피를 진행하다보니 위와 같은 결과가 나온것이라고 추측할 수 있겠네요.

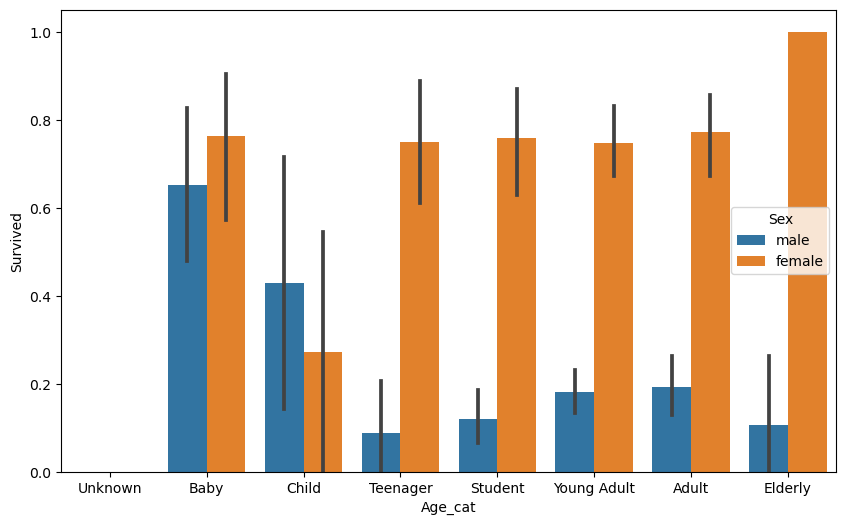

## 입력 age에 따라 구분값을 반환하는 함수 설정. DataFrame의 apply lambda식에 사용.

def get_category(age):

cat = ''

if age <= -1: cat = 'Unknown'

elif age <= 5: cat = 'Baby'

elif age <= 12: cat = 'Child'

elif age <= 18: cat = 'Teenager'

elif age <= 25: cat = 'Student'

elif age <= 35: cat = 'Young Adult'

elif age <= 60: cat = 'Adult'

else : cat = 'Elderly'

return cat

# 막대그래프의 크기 figure를 더 크게 설정

plt.figure(figsize=(10,6))

#X축의 값을 순차적으로 표시하기 위한 설정

group_names = ['Unknown', 'Baby', 'Child', 'Teenager', 'Student', 'Young Adult', 'Adult', 'Elderly']

# lambda 식에 위에서 생성한 get_category( ) 함수를 반환값으로 지정.

# get_category(X)는 입력값으로 'Age' 컬럼값을 받아서 해당하는 cat 반환

titanic_df['Age_cat'] = titanic_df['Age'].apply(lambda x : get_category(x))

sns.barplot(x='Age_cat', y = 'Survived', hue='Sex', data=titanic_df, order=group_names)

titanic_df.drop('Age_cat', axis=1, inplace=True)

2.2. 데이터 준비

from sklearn.preprocessing import LabelEncoder

# Null 처리 함수

def fillna(df):

df['Age'].fillna(df['Age'].mean(),inplace=True)

df['Cabin'].fillna('N',inplace=True)

df['Embarked'].fillna('N',inplace=True)

df['Fare'].fillna(0,inplace=True)

return df

# 머신러닝 알고리즘에 불필요한 속성 제거

def drop_features(df):

df.drop(['PassengerId','Name','Ticket'],axis=1,inplace=True)

return df

# 레이블 인코딩 수행.

def format_features(df):

df['Cabin'] = df['Cabin'].str[:1]

features = ['Cabin','Sex','Embarked']

for feature in features:

le = LabelEncoder()

le = le.fit(df[feature])

df[feature] = le.transform(df[feature])

return df

# 앞에서 설정한 Data Preprocessing 함수 호출

def transform_features(df):

df = fillna(df)

df = drop_features(df)

df = format_features(df)

return df2.3. 데이터 분리

import pandas as pd

from sklearn.model_selection import train_test_split

# 원본 데이터를 재로딩 하고, feature데이터 셋과 Label 데이터 셋 추출.

titanic_df = pd.read_csv('./train.csv')

y_titanic_df = titanic_df['Survived']

X_titanic_df= titanic_df.drop('Survived',axis=1)

X_titanic_df = transform_features(X_titanic_df)

X_train, X_test, y_train, y_test=train_test_split(X_titanic_df, y_titanic_df, \

test_size=0.2, random_state=11)2.4. 모델학습 및 적용

from sklearn.tree import DecisionTreeClassifier

from sklearn.ensemble import RandomForestClassifier

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

# 결정트리, Random Forest, 로지스틱 회귀를 위한 사이킷런 Classifier 클래스 생성

dt_clf = DecisionTreeClassifier(random_state=11)

rf_clf = RandomForestClassifier(random_state=11)

lr_clf = LogisticRegression()

# DecisionTreeClassifier 학습/예측/평가

dt_clf.fit(X_train , y_train)

dt_pred = dt_clf.predict(X_test)

print('DecisionTreeClassifier 정확도: {0:.4f}'.format(accuracy_score(y_test, dt_pred)))

# RandomForestClassifier 학습/예측/평가

rf_clf.fit(X_train , y_train)

rf_pred = rf_clf.predict(X_test)

print('RandomForestClassifier 정확도:{0:.4f}'.format(accuracy_score(y_test, rf_pred)))

# LogisticRegression 학습/예측/평가

lr_clf.fit(X_train , y_train)

lr_pred = lr_clf.predict(X_test)

print('LogisticRegression 정확도: {0:.4f}'.format(accuracy_score(y_test, lr_pred)))특별한 파라미터를 조정하지않은 상태에서 가장 높은 정확도는 logisticRegression 모델이 해당 데이터를 가장 잘 표현하는 모델인것을 확인 할 수 있습니다.

**결과값**

DecisionTreeClassifier 정확도: 0.7877

RandomForestClassifier 정확도:0.8547

LogisticRegression 정확도: 0.84922.5. 교차검증

from sklearn.model_selection import KFold

def exec_kfold(clf, folds=5):

# 폴드 세트를 5개인 KFold객체를 생성, 폴드 수만큼 예측결과 저장을 위한 리스트 객체 생성.

kfold = KFold(n_splits=folds)

scores = []

# KFold 교차 검증 수행.

for iter_count , (train_index, test_index) in enumerate(kfold.split(X_titanic_df)):

# X_titanic_df 데이터에서 교차 검증별로 학습과 검증 데이터를 가리키는 index 생성

X_train, X_test = X_titanic_df.values[train_index], X_titanic_df.values[test_index]

y_train, y_test = y_titanic_df.values[train_index], y_titanic_df.values[test_index]

# Classifier 학습, 예측, 정확도 계산

clf.fit(X_train, y_train)

predictions = clf.predict(X_test)

accuracy = accuracy_score(y_test, predictions)

scores.append(accuracy)

print("교차 검증 {0} 정확도: {1:.4f}".format(iter_count, accuracy))

# 5개 fold에서의 평균 정확도 계산.

mean_score = np.mean(scores)

print("평균 정확도: {0:.4f}".format(mean_score))

# exec_kfold 호출

exec_kfold(dt_clf , folds=5)**결과값**

교차 검증 0 정확도: 0.7542

교차 검증 1 정확도: 0.7809

교차 검증 2 정확도: 0.7865

교차 검증 3 정확도: 0.7697

교차 검증 4 정확도: 0.8202

평균 정확도: 0.7823

from sklearn.model_selection import cross_val_score

scores = cross_val_score(dt_clf, X_titanic_df , y_titanic_df , cv=5)

for iter_count,accuracy in enumerate(scores):

print("교차 검증 {0} 정확도: {1:.4f}".format(iter_count, accuracy))

print("평균 정확도: {0:.4f}".format(np.mean(scores)))**결과값**

교차 검증 0 정확도: 0.7430

교차 검증 1 정확도: 0.7753

교차 검증 2 정확도: 0.7921

교차 검증 3 정확도: 0.7865

교차 검증 4 정확도: 0.8427

평균 정확도: 0.7879

from sklearn.model_selection import GridSearchCV

parameters = {'max_depth':[2,3,5,10],

'min_samples_split':[2,3,5], 'min_samples_leaf':[1,5,8]}

grid_dclf = GridSearchCV(dt_clf , param_grid=parameters , scoring='accuracy' , cv=5)

grid_dclf.fit(X_train , y_train)

print('GridSearchCV 최적 하이퍼 파라미터 :',grid_dclf.best_params_)

print('GridSearchCV 최고 정확도: {0:.4f}'.format(grid_dclf.best_score_))

best_dclf = grid_dclf.best_estimator_

# GridSearchCV의 최적 하이퍼 파라미터로 학습된 Estimator로 예측 및 평가 수행.

dpredictions = best_dclf.predict(X_test)

accuracy = accuracy_score(y_test , dpredictions)

print('테스트 세트에서의 DecisionTreeClassifier 정확도 : {0:.4f}'.format(accuracy))**결과값**

GridSearchCV 최적 하이퍼 파라미터 : {'max_depth': 3, 'min_samples_leaf': 5, 'min_samples_split': 2}

GridSearchCV 최고 정확도: 0.7992

테스트 세트에서의 DecisionTreeClassifier 정확도 : 0.8715Reference

- 파이썬 머신러닝 완벽가이드 github : https://github.com/wikibook/ml-definitive-guide

'Python > 2️⃣ 데이터 처리' 카테고리의 다른 글

| 1변량 & 다변량 데이터 및 시각화 방안(with python) (0) | 2023.02.13 |

|---|---|

| 불편분산은 왜 n-1로 나누지? (0) | 2023.02.12 |

| [머신러닝] 사이킷런으로 시작하는 머신러닝 (0) | 2023.02.06 |

| [알고리즘] 각도기 (0) | 2023.01.12 |

| [Kaggle]Binary classification : Tabular data (0) | 2022.08.15 |

주제: 타이타닉 생존자 예측하기

작성: 2023-02-05

활용데이터: https://www.kaggle.com/competitions/titanic/data

안녕하세요, WSCODE 루카스입니다.

사이킷런으로 수행하는 타이타닉 생존자 예측해보도록 하겠습니다.

1. 데이터 다운로드

우선, 데이터확보가 필요합니다. 데이터는 kaggle 제공하는 타이타닉 생존자 데이터를 활용하도록 하겠습니다.

하단의 링크를 클릭하시면, 데이터의 간략한 설명 및 각 레이블이 의미하는 값이 무엇인지 설명되어 있습니다.

혹시라도 귀찮으신분들은 데이터파일 참보하였으니 다운로드하셔서 진행하시면 됩니다.

1. 전체 소스코드

우선 전체 소스코드입니다.

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

%matplotlib inline

## 데이터 불러오기

titanic_df = pd.read_csv('./train.csv')

titanic_df.info()

## 데이터 확인 및 EDA

titanic_df['Age'].fillna(titanic_df['Age'].mean(),inplace=True)

titanic_df['Cabin'].fillna('N',inplace=True)

titanic_df['Embarked'].fillna('N',inplace=True)

print('데이터 세트 Null 값 갯수 ',titanic_df.isnull().sum().sum())

print(' Sex 값 분포 :\n',titanic_df['Sex'].value_counts())

print('\n Cabin 값 분포 :\n',titanic_df['Cabin'].value_counts())

print('\n Embarked 값 분포 :\n',titanic_df['Embarked'].value_counts())

titanic_df['Cabin'] = titanic_df['Cabin'].str[:1]

print(titanic_df['Cabin'].head(3))

titanic_df.groupby(['Sex','Survived'])['Survived'].count()

sns.barplot(x='Sex', y = 'Survived', data=titanic_df)

sns.barplot(x='Pclass', y='Survived', hue='Sex', data=titanic_df)

## 입력 age에 따라 구분값을 반환하는 함수 설정. DataFrame의 apply lambda식에 사용.

def get_category(age):

cat = ''

if age <= -1: cat = 'Unknown'

elif age <= 5: cat = 'Baby'

elif age <= 12: cat = 'Child'

elif age <= 18: cat = 'Teenager'

elif age <= 25: cat = 'Student'

elif age <= 35: cat = 'Young Adult'

elif age <= 60: cat = 'Adult'

else : cat = 'Elderly'

return cat

# 막대그래프의 크기 figure를 더 크게 설정

plt.figure(figsize=(10,6))

#X축의 값을 순차적으로 표시하기 위한 설정

group_names = ['Unknown', 'Baby', 'Child', 'Teenager', 'Student', 'Young Adult', 'Adult', 'Elderly']

# lambda 식에 위에서 생성한 get_category( ) 함수를 반환값으로 지정.

# get_category(X)는 입력값으로 'Age' 컬럼값을 받아서 해당하는 cat 반환

titanic_df['Age_cat'] = titanic_df['Age'].apply(lambda x : get_category(x))

sns.barplot(x='Age_cat', y = 'Survived', hue='Sex', data=titanic_df, order=group_names)

titanic_df.drop('Age_cat', axis=1, inplace=True)

from sklearn.preprocessing import LabelEncoder

# Null 처리 함수

def fillna(df):

df['Age'].fillna(df['Age'].mean(),inplace=True)

df['Cabin'].fillna('N',inplace=True)

df['Embarked'].fillna('N',inplace=True)

df['Fare'].fillna(0,inplace=True)

return df

# 머신러닝 알고리즘에 불필요한 속성 제거

def drop_features(df):

df.drop(['PassengerId','Name','Ticket'],axis=1,inplace=True)

return df

# 레이블 인코딩 수행.

def format_features(df):

df['Cabin'] = df['Cabin'].str[:1]

features = ['Cabin','Sex','Embarked']

for feature in features:

le = LabelEncoder()

le = le.fit(df[feature])

df[feature] = le.transform(df[feature])

return df

# 앞에서 설정한 Data Preprocessing 함수 호출

def transform_features(df):

df = fillna(df)

df = drop_features(df)

df = format_features(df)

return df

# 원본 데이터를 재로딩 하고, feature데이터 셋과 Label 데이터 셋 추출.

titanic_df = pd.read_csv('./titanic_train.csv')

y_titanic_df = titanic_df['Survived']

X_titanic_df= titanic_df.drop('Survived',axis=1)

X_titanic_df = transform_features(X_titanic_df)

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test=train_test_split(X_titanic_df, y_titanic_df, \

test_size=0.2, random_state=11)

from sklearn.tree import DecisionTreeClassifier

from sklearn.ensemble import RandomForestClassifier

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

# 결정트리, Random Forest, 로지스틱 회귀를 위한 사이킷런 Classifier 클래스 생성

dt_clf = DecisionTreeClassifier(random_state=11)

rf_clf = RandomForestClassifier(random_state=11)

lr_clf = LogisticRegression()

# DecisionTreeClassifier 학습/예측/평가

dt_clf.fit(X_train , y_train)

dt_pred = dt_clf.predict(X_test)

print('DecisionTreeClassifier 정확도: {0:.4f}'.format(accuracy_score(y_test, dt_pred)))

# RandomForestClassifier 학습/예측/평가

rf_clf.fit(X_train , y_train)

rf_pred = rf_clf.predict(X_test)

print('RandomForestClassifier 정확도:{0:.4f}'.format(accuracy_score(y_test, rf_pred)))

# LogisticRegression 학습/예측/평가

lr_clf.fit(X_train , y_train)

lr_pred = lr_clf.predict(X_test)

print('LogisticRegression 정확도: {0:.4f}'.format(accuracy_score(y_test, lr_pr

from sklearn.model_selection import KFold

def exec_kfold(clf, folds=5):

# 폴드 세트를 5개인 KFold객체를 생성, 폴드 수만큼 예측결과 저장을 위한 리스트 객체 생성.

kfold = KFold(n_splits=folds)

scores = []

# KFold 교차 검증 수행.

for iter_count , (train_index, test_index) in enumerate(kfold.split(X_titanic_df)):

# X_titanic_df 데이터에서 교차 검증별로 학습과 검증 데이터를 가리키는 index 생성

X_train, X_test = X_titanic_df.values[train_index], X_titanic_df.values[test_index]

y_train, y_test = y_titanic_df.values[train_index], y_titanic_df.values[test_index]

# Classifier 학습, 예측, 정확도 계산

clf.fit(X_train, y_train)

predictions = clf.predict(X_test)

accuracy = accuracy_score(y_test, predictions)

scores.append(accuracy)

print("교차 검증 {0} 정확도: {1:.4f}".format(iter_count, accuracy))

# 5개 fold에서의 평균 정확도 계산.

mean_score = np.mean(scores)

print("평균 정확도: {0:.4f}".format(mean_score))

# exec_kfold 호출

exec_kfold(dt_clf , folds=5)

from sklearn.model_selection import cross_val_score

scores = cross_val_score(dt_clf, X_titanic_df , y_titanic_df , cv=5)

for iter_count,accuracy in enumerate(scores):

print("교차 검증 {0} 정확도: {1:.4f}".format(iter_count, accuracy))

print("평균 정확도: {0:.4f}".format(np.mean(scores)))

from sklearn.model_selection import GridSearchCV

parameters = {'max_depth':[2,3,5,10],

'min_samples_split':[2,3,5], 'min_samples_leaf':[1,5,8]}

grid_dclf = GridSearchCV(dt_clf , param_grid=parameters , scoring='accuracy' , cv=5)

grid_dclf.fit(X_train , y_train)

print('GridSearchCV 최적 하이퍼 파라미터 :',grid_dclf.best_params_)

print('GridSearchCV 최고 정확도: {0:.4f}'.format(grid_dclf.best_score_))

best_dclf = grid_dclf.best_estimator_

# GridSearchCV의 최적 하이퍼 파라미터로 학습된 Estimator로 예측 및 평가 수행.

dpredictions = best_dclf.predict(X_test)

accuracy = accuracy_score(y_test , dpredictions)

print('테스트 세트에서의 DecisionTreeClassifier 정확도 : {0:.4f}'.format(accuracy))

2. 코드 이해하기

2.1. 탐색적 데이터 분석(EDA, Exploratory Data Analysis)

우선은 데이터가 어떠한 특성을 가지고 있는지를 사전에 탐색하는 작업이 바로 EDA 입니다.

그럼 우선 생존자의 남여 성비구성은 어떤지 확인해보도록 하겠습니다.

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

%matplotlib inline

## 데이터 불러오기

titanic_df = pd.read_csv('./train.csv')

titanic_df.info()

## 데이터 전처리

titanic_df['Age'].fillna(titanic_df['Age'].mean(),inplace=True)

titanic_df['Cabin'].fillna('N',inplace=True)

titanic_df['Embarked'].fillna('N',inplace=True)

print('데이터 세트 Null 값 갯수 ',titanic_df.isnull().sum().sum())

## 데이터 확인

titanic_df.groupby(['Sex','Survived'])['Survived'].count()

sns.barplot(x='Sex', y = 'Survived', data=titanic_df)

sns.barplot(x='Pclass', y='Survived', hue='Sex', data=titanic_df)

해당 데이터만으로 같은 조건에서는 남성보다 여성이 더 생존능력이 뛰어나다 라고 분석을 하는건 너무 성급한 일반화의 오류일 듯합니다.

그럼 과연 왜 여성 생존률이 남성보다 높게 나왔을까요?

아마 필자는 그 이유가 선박 안전 프로토콜 때문이 아닐까싶습니다. 대부분 안전프로토콜의 경우, 어린이 및 노약자, 여성, 남성순으로 대피를 진행합니다. 아마 초반에 구명보트에 이 순서대로 대피를 진행하다보니 위와 같은 결과가 나온것이라고 추측할 수 있겠네요.

## 입력 age에 따라 구분값을 반환하는 함수 설정. DataFrame의 apply lambda식에 사용.

def get_category(age):

cat = ''

if age <= -1: cat = 'Unknown'

elif age <= 5: cat = 'Baby'

elif age <= 12: cat = 'Child'

elif age <= 18: cat = 'Teenager'

elif age <= 25: cat = 'Student'

elif age <= 35: cat = 'Young Adult'

elif age <= 60: cat = 'Adult'

else : cat = 'Elderly'

return cat

# 막대그래프의 크기 figure를 더 크게 설정

plt.figure(figsize=(10,6))

#X축의 값을 순차적으로 표시하기 위한 설정

group_names = ['Unknown', 'Baby', 'Child', 'Teenager', 'Student', 'Young Adult', 'Adult', 'Elderly']

# lambda 식에 위에서 생성한 get_category( ) 함수를 반환값으로 지정.

# get_category(X)는 입력값으로 'Age' 컬럼값을 받아서 해당하는 cat 반환

titanic_df['Age_cat'] = titanic_df['Age'].apply(lambda x : get_category(x))

sns.barplot(x='Age_cat', y = 'Survived', hue='Sex', data=titanic_df, order=group_names)

titanic_df.drop('Age_cat', axis=1, inplace=True)

2.2. 데이터 준비

from sklearn.preprocessing import LabelEncoder

# Null 처리 함수

def fillna(df):

df['Age'].fillna(df['Age'].mean(),inplace=True)

df['Cabin'].fillna('N',inplace=True)

df['Embarked'].fillna('N',inplace=True)

df['Fare'].fillna(0,inplace=True)

return df

# 머신러닝 알고리즘에 불필요한 속성 제거

def drop_features(df):

df.drop(['PassengerId','Name','Ticket'],axis=1,inplace=True)

return df

# 레이블 인코딩 수행.

def format_features(df):

df['Cabin'] = df['Cabin'].str[:1]

features = ['Cabin','Sex','Embarked']

for feature in features:

le = LabelEncoder()

le = le.fit(df[feature])

df[feature] = le.transform(df[feature])

return df

# 앞에서 설정한 Data Preprocessing 함수 호출

def transform_features(df):

df = fillna(df)

df = drop_features(df)

df = format_features(df)

return df2.3. 데이터 분리

import pandas as pd

from sklearn.model_selection import train_test_split

# 원본 데이터를 재로딩 하고, feature데이터 셋과 Label 데이터 셋 추출.

titanic_df = pd.read_csv('./train.csv')

y_titanic_df = titanic_df['Survived']

X_titanic_df= titanic_df.drop('Survived',axis=1)

X_titanic_df = transform_features(X_titanic_df)

X_train, X_test, y_train, y_test=train_test_split(X_titanic_df, y_titanic_df, \

test_size=0.2, random_state=11)2.4. 모델학습 및 적용

from sklearn.tree import DecisionTreeClassifier

from sklearn.ensemble import RandomForestClassifier

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

# 결정트리, Random Forest, 로지스틱 회귀를 위한 사이킷런 Classifier 클래스 생성

dt_clf = DecisionTreeClassifier(random_state=11)

rf_clf = RandomForestClassifier(random_state=11)

lr_clf = LogisticRegression()

# DecisionTreeClassifier 학습/예측/평가

dt_clf.fit(X_train , y_train)

dt_pred = dt_clf.predict(X_test)

print('DecisionTreeClassifier 정확도: {0:.4f}'.format(accuracy_score(y_test, dt_pred)))

# RandomForestClassifier 학습/예측/평가

rf_clf.fit(X_train , y_train)

rf_pred = rf_clf.predict(X_test)

print('RandomForestClassifier 정확도:{0:.4f}'.format(accuracy_score(y_test, rf_pred)))

# LogisticRegression 학습/예측/평가

lr_clf.fit(X_train , y_train)

lr_pred = lr_clf.predict(X_test)

print('LogisticRegression 정확도: {0:.4f}'.format(accuracy_score(y_test, lr_pred)))특별한 파라미터를 조정하지않은 상태에서 가장 높은 정확도는 logisticRegression 모델이 해당 데이터를 가장 잘 표현하는 모델인것을 확인 할 수 있습니다.

**결과값**

DecisionTreeClassifier 정확도: 0.7877

RandomForestClassifier 정확도:0.8547

LogisticRegression 정확도: 0.84922.5. 교차검증

from sklearn.model_selection import KFold

def exec_kfold(clf, folds=5):

# 폴드 세트를 5개인 KFold객체를 생성, 폴드 수만큼 예측결과 저장을 위한 리스트 객체 생성.

kfold = KFold(n_splits=folds)

scores = []

# KFold 교차 검증 수행.

for iter_count , (train_index, test_index) in enumerate(kfold.split(X_titanic_df)):

# X_titanic_df 데이터에서 교차 검증별로 학습과 검증 데이터를 가리키는 index 생성

X_train, X_test = X_titanic_df.values[train_index], X_titanic_df.values[test_index]

y_train, y_test = y_titanic_df.values[train_index], y_titanic_df.values[test_index]

# Classifier 학습, 예측, 정확도 계산

clf.fit(X_train, y_train)

predictions = clf.predict(X_test)

accuracy = accuracy_score(y_test, predictions)

scores.append(accuracy)

print("교차 검증 {0} 정확도: {1:.4f}".format(iter_count, accuracy))

# 5개 fold에서의 평균 정확도 계산.

mean_score = np.mean(scores)

print("평균 정확도: {0:.4f}".format(mean_score))

# exec_kfold 호출

exec_kfold(dt_clf , folds=5)**결과값**

교차 검증 0 정확도: 0.7542

교차 검증 1 정확도: 0.7809

교차 검증 2 정확도: 0.7865

교차 검증 3 정확도: 0.7697

교차 검증 4 정확도: 0.8202

평균 정확도: 0.7823

from sklearn.model_selection import cross_val_score

scores = cross_val_score(dt_clf, X_titanic_df , y_titanic_df , cv=5)

for iter_count,accuracy in enumerate(scores):

print("교차 검증 {0} 정확도: {1:.4f}".format(iter_count, accuracy))

print("평균 정확도: {0:.4f}".format(np.mean(scores)))**결과값**

교차 검증 0 정확도: 0.7430

교차 검증 1 정확도: 0.7753

교차 검증 2 정확도: 0.7921

교차 검증 3 정확도: 0.7865

교차 검증 4 정확도: 0.8427

평균 정확도: 0.7879

from sklearn.model_selection import GridSearchCV

parameters = {'max_depth':[2,3,5,10],

'min_samples_split':[2,3,5], 'min_samples_leaf':[1,5,8]}

grid_dclf = GridSearchCV(dt_clf , param_grid=parameters , scoring='accuracy' , cv=5)

grid_dclf.fit(X_train , y_train)

print('GridSearchCV 최적 하이퍼 파라미터 :',grid_dclf.best_params_)

print('GridSearchCV 최고 정확도: {0:.4f}'.format(grid_dclf.best_score_))

best_dclf = grid_dclf.best_estimator_

# GridSearchCV의 최적 하이퍼 파라미터로 학습된 Estimator로 예측 및 평가 수행.

dpredictions = best_dclf.predict(X_test)

accuracy = accuracy_score(y_test , dpredictions)

print('테스트 세트에서의 DecisionTreeClassifier 정확도 : {0:.4f}'.format(accuracy))**결과값**

GridSearchCV 최적 하이퍼 파라미터 : {'max_depth': 3, 'min_samples_leaf': 5, 'min_samples_split': 2}

GridSearchCV 최고 정확도: 0.7992

테스트 세트에서의 DecisionTreeClassifier 정확도 : 0.8715Reference

- 파이썬 머신러닝 완벽가이드 github : https://github.com/wikibook/ml-definitive-guide

'Python > 2️⃣ 데이터 처리' 카테고리의 다른 글

| 1변량 & 다변량 데이터 및 시각화 방안(with python) (0) | 2023.02.13 |

|---|---|

| 불편분산은 왜 n-1로 나누지? (0) | 2023.02.12 |

| [머신러닝] 사이킷런으로 시작하는 머신러닝 (0) | 2023.02.06 |

| [알고리즘] 각도기 (0) | 2023.01.12 |

| [Kaggle]Binary classification : Tabular data (0) | 2022.08.15 |